Computação na memória

Uma equipe da Universidade da Pensilvânia e dos laboratórios nacionais Sandia e Brookhaven, nos EUA, apresentou uma arquitetura de computação ideal para inteligência artificial.

Nos computadores atuais, o armazenamento de memória e a computação propriamente dita ocorrem em diferentes partes da máquina, e os dados devem ser movidos da memória para a CPU ou GPU para processamento. E isso leva tempo, o que é um problema quando se considera o enorme volume de dados necessários para treinar os algoritmos de aprendizado de máquina.

Xiwen Liu e seus colegas então se voltaram para uma arquitetura conhecida como “computação na memória“, em que o processamento e o armazenamento ocorrem no mesmo local, eliminando o tempo de transferência e minimizando o consumo de energia.

Já existem diversas implementações experimentais desse tipo, mas o que chama atenção no novo projeto é que ele é completamente livre de transistores.

“Mesmo quando usados em uma arquitetura de computação em memória, os transistores comprometem o tempo de acesso aos dados,” explicou o professor Deep Jariwala. “Eles exigem muita fiação no circuito geral de um chip e, portanto, usam tempo, espaço e energia além do que desejaríamos para aplicações de IA. A beleza do nosso design livre de transistores é que ele é simples, pequeno e rápido e requer muito pouca energia.”

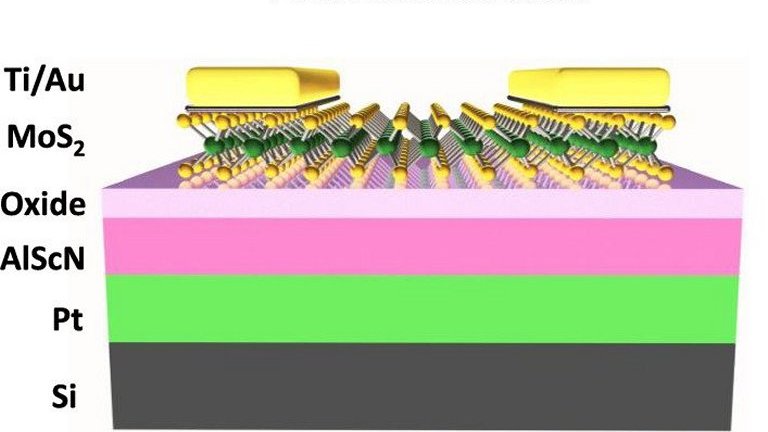

Estrutura do componente que substitui o transístor, funcionando como memória e como unidade de computação.

Processador sem transístor

Para se livrar dos transistores, a equipe se valeu de um novo semicondutor, o nitreto de alumínio com liga de escândio (AlScN), que permite a comutação ferroelétrica, cuja física é mais rápida e mais eficiente em termos de energia do que outros componentes de memória não volátil.

A ferroeletricidade pode ser considerada uma análoga do ferromagnetismo. Um material ferromagnético apresenta magnetismo permanente e, em termos simples, é um ímã com pólos norte e sul – e isso permite que ele armazene dados. E, como ele também armazena cargas elétricas, o componente sozinho é suficiente para fazer as computações.

O semicondutor foi usado para construir um componente chamado ferrodiodo, ou diodo ferroelétrico, que consegue chavear até 100 vezes mais rápido do que os transistores convencionais.

“Um dos principais atributos deste material é que ele pode ser depositado em temperaturas baixas o suficiente para ser compatível com as fundições de silício. A maioria dos materiais ferroelétricos requer temperaturas muito mais altas. As propriedades especiais do AlScN significam que nossos componentes de memória aqui demonstrados podem ir no topo da camada de silício em uma pilha vertical heterointegrada.

“Pense na diferença entre um estacionamento de vários andares com capacidade para cem carros e uma centena de vagas de estacionamento individuais distribuídas em um terreno. Qual é mais eficiente em termos de espaço? O mesmo vale para informações e componentes em um chip altamente miniaturizado como o nosso. Essa eficiência é tão importante para aplicações que exigem restrições de recursos, como dispositivos móveis ou vestíveis, como é para aplicativos que consomem muita energia, como data centers,” explicou o professor Roy Olsson.

“É importante perceber que toda a computação de IA que é feita atualmente é habilitada por software em uma arquitetura de hardware de silício projetada décadas atrás,” disse Jariwala. “É por isso que a inteligência artificial como um campo tem sido dominada por engenheiros de computador e de software. Reprojetar fundamentalmente o hardware para IA será o próximo grande divisor de águas em semicondutores e microeletrônicos. A direção em que estamos indo agora é a de coprojetar hardware e software.”

Fonte: Redação do Site Inovação Tecnológica – 11/10/2022